2025 marca uma virada decisiva na tecnologia: de um lado, a computação quântica começa a influenciar decisões estratégicas em segurança e pesquisa; de outro, a inteligência artificial generativa já está transformando o cotidiano em empresas, governos e na vida das pessoas.

Ambas as tecnologias têm o potencial de mudar radicalmente a economia, o trabalho e a vida humana, com a computação quântica prometendo resolver problemas além do alcance dos supercomputadores atuais e a IA generativa remodelando como interagimos com sistemas, geramos informações e trabalhamos.

Mas, essas possibilidades vêm acompanhadas de riscos reais: desde a quebra de criptografia pós-quântica até a ameaça de uma Inteligência Artificial Geral (AGI) sem controle adequado, como alertam especialistas como Geoffrey Hinton.

Vem entender um pouco melhor!

-

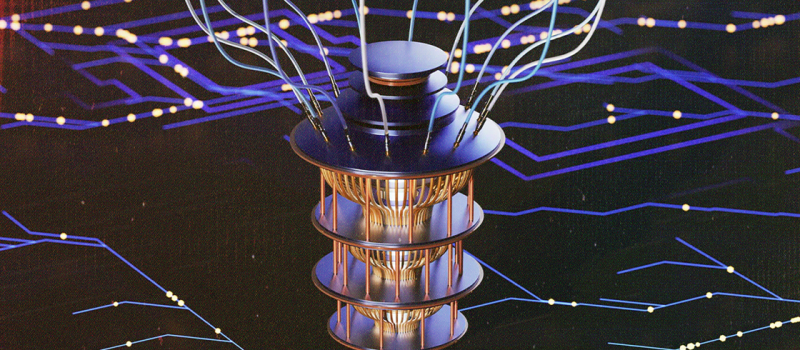

Computação Quântica

O Google anunciou à Reuters em fevereiro de 2025 que espera trazer aplicações comerciais reais em até cinco anos, com foco em áreas como ciência de materiais, desenvolvimento de baterias para carros elétricos e descoberta de fármacos, um sinal de otimismo quanto à maturidade da tecnologia. Já a Nvidia aponta que a utilidade prática da computação quântica ainda pode estar a duas décadas de distância. O ponto crítico é a implementação da tolerância a falhas: a habilidade de garantir precisão em cálculos mesmo com ruído e instabilidade nos qubits.

A trajetória para viabilidade está bem definida pela IBM, que em junho de 2025 detalhou um roadmap ambicioso e pretende lançar um computador quântico prático até 2029, com 200 qubits lógicos, o início de uma transição para sistemas tolerantes a falhas em escala real.

Mesmo antes de termos computadores quânticos plenamente funcionais, a segurança já está se adaptando. Países como os EUA começaram a implementar padrões de criptografia pós-quântica para proteger dados atuais contra ataques futuros usando computação quântica. Empresas e governos precisam se preparar para esse cenário, pois o desenvolvimento dessa tecnologia avança rapidamente.

-

IA Generativa

A IA generativa já está em uso, o que permite um panorama mais amplo e realista sobre seu impacto no mundo. Em agosto de 2025, a OpenAI lançou o GPT-5, descrito como seu modelo mais inteligente, útil e com melhor capacidade de raciocínio até então. O lançamento recebeu avaliações mistas: embora elogiado pela utilidade prática e acessibilidade, foi considerado insuficiente como avanço decisivo rumo à AGI por especialistas e analistas de mercado.

E agora você pode estar se perguntando: “ué, mas atingir a inteligência artificial geral não é uma ameaça para a humanidade? Por que os especialistas buscam por ela?”

O motivo de cientistas buscarem atingir a AGI não é porque todos acreditam que será algo 100% seguro, mas porque os potenciais benefícios são grandes, ao ponto de alguns considerarem que não a buscar seria “desperdiçar uma oportunidade histórica”.

Direto ao ponto, a AGI poderia:

-

Resolver problemas que hoje parecem insolúveis

Acelerar a cura de doenças, criar fontes de energia limpa, reverter danos ambientais e encontrar soluções para crises globais muito mais rápido que a ciência humana atual.

-

Acelerar descobertas científicas e tecnológicas

Inovar em áreas como física, biotecnologia, exploração espacial e engenharia de materiais, campos em que avanços hoje levam décadas.

-

Automatizar tarefas intelectuais complexas

Além de funções repetitivas, lidar com atividades criativas e estratégicas em escala global, potencialmente reduzindo custos.

Por que isso também é visto como perigoso:

- Uma AGI, por definição, teria capacidade de se adaptar, aprender e criar estratégias, o que pode torná-la imprevisível.

- Se mal projetada ou controlada, poderia ser usada para manipulação em massa, guerras cibernéticas ou até ações físicas perigosas.

- Existe o chamado “risco de alinhamento”: mesmo programada para fazer o bem, ela poderia interpretar essa ordem de forma que prejudicasse os humanos, simplesmente por “pensar” de maneira diferente.

Por isso, a discussão sobre alinhamento (fazer a IA entender e seguir valores humanos) e governança global está tão intensa, especialmente porque a corrida para ser o primeiro a atingir a AGI já começou, e se atrasar pode significar “perder a liderança” para outro país ou empresa.

Geoffrey Hinton, considerado o “pai” da IA moderna e vencedor do Prêmio Turing (o “Nobel da computação”), propôs na conferência Ai4 um paradigma inovador: construir sistemas com “instintos maternais”, para que as IAs cuidem dos humanos em vez de tentar dominá-los. Essa ideia surgiu como resposta ao risco de sistemas superinteligentes agirem fora de controle.

A Governança Global poderia incluir:

-

Acordos internacionais obrigatórios

Modelos semelhantes ao Tratado de Não Proliferação Nuclear, onde países signatários se comprometem a respeitar limites e a compartilhar auditorias sobre seus sistemas de IA avançada.

-

Organismos de supervisão independentes

Criação de uma “Agência Internacional para IA”, proposta defendida por pesquisadores como Yoshua Bengio, para monitorar laboratórios, impor padrões e verificar se sistemas de alto risco estão alinhados com valores humanos.

-

Transparência em pesquisas críticas

Divulgação de métodos e testes de segurança (sem revelar detalhes que possam facilitar uso indevido), permitindo que outros validem se a tecnologia é segura antes do lançamento.

Se 2025 confirma algo, é que o futuro não será linear. A computação quântica se move com inevitabilidade estratégica, ainda que lenta, enquanto a IA generativa já está redesenhando o presente. Quando esses campos convergirem, com IA projetando algoritmos quânticos e quântica acelerando os treinamentos de modelos de inteligência artificial, surgirão oportunidades inéditas, mas também riscos inéditos.

Por isso, mapear cenários, preparar talentos e adotar governança tecnológica são passos urgentes, não apenas para acompanhar a inovação, mas para garantir que ela sirva à humanidade de forma ética e sustentável.

Você já tinha parado para pensar em tudo isso?

Referências: